當今為了加速部署大規模的機器學習 (Mechine Learning, ML) 應用程式並實現未來ML 應用程式的快速開發,Google 建立了名為 Tensor Processing Units (TPUs) 的客製化晶片。當組裝成名為 Cloud TPU Pods 的多組機架 ML 超級計算機時,這些 TPUs 能夠在幾分鐘或幾小時內完成 ML 工作負載,然而這些工作以前在其他系統上是需要數天或數週才能在完成。今天首次 Google Cloud TPU v2 Pods 及 Cloud TPU v3 Pods 正式發布 Beta 版本,來幫助 ML 研究員、工程師以及數據科學家更快的迭代並訓練更強大的機器學習模型。

傳遞商業價值

Google Cloud 正致力於提供全方位的 ML 加速器,包含 Cloud GPUs 及 Cloud TPUs。Cloud TPUs 提供極具競爭力的性能及較低的成本,可以更快的訓練最新的深度學習模型,同時節省大量成本。假如您的 ML 團隊正在建立複雜的模型且訓練的資料集非常大,我們建議您在需要時評估 Cloud TPUs:

- 更短的洞察時間 — 可以更快的反覆訓練大型 ML 模型

- 更高的準確性 — 使用更大型的資料集 ( 數百萬個標籤範例;TB 至 PB 等級的資料量 ) 來訓練更精確的模型

- 頻繁的模型更新 — 每日或每週有新的資料進入時,重新訓練模型

- 快速雛形設計 — 使用我們在圖像分割、對象偵測、語言處理及其他主要應用領域中最佳化的開源參考模型快速啟動。

雖然一些客製晶片只能運行單一功能,但 TPUs 卻是完全可程序化的,這意味 Cloud TPU Pods 能夠加速各種最先進的 ML 工作負載,其中包含許多最受歡迎的深度學習模型。例如,一個 Cloud TPU v3 Pod 可以在短短 2分鐘 內從 ImageNet 資料集上從頭開始訓練 ResNet-50 (圖像分類),或訓練 BERT (NLP) 只需 76 分鐘。

Cloud TPU 客戶看到了可視覺化產品搜尋、財務建模、能源生產及其他領域工作負載大幅提升。在最近的個案研究中,Recursion Pharmaceuticals 反覆測試合成分子的可行性來治療罕見疾病。在他們事先設置的叢集中訓練需要超過 24 小時才能完成,但在 Cloud TPU Pod 上只需要 15 分鐘。

Cloud TPU Pod 有什麼

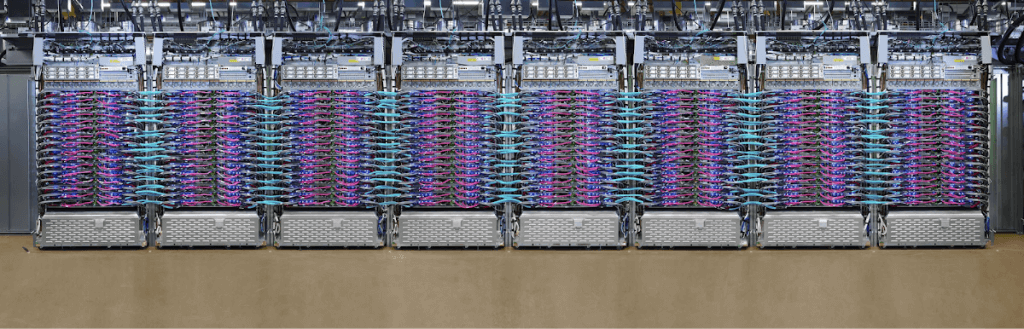

單一個 Cloud TPU Pod 能由超過 1,000 個單獨的 TPU 芯片組成,這些芯片透過一個超快速的二維環形網狀網連接在一起,如同下圖所示。TPU 軟體堆疊使用此網狀網路,通過各種靈活、高級 API ,可以將許多機架程序化為單個巨型 ML 超級計算機。

2D 環形網狀網路

最新一代的 Cloud TPU v3 Pods 採用水冷式來達到最高的效能,且每個 TPU Pods 都可以提供超過 100 petaFLOPs 的運算效能。以每秒數學運算來說,一個 Cloud TPU v3 Pods 能夠與世界上前五大超級計算機匹敵 (儘管它是以較低的數值精度運行)。

也可以使用名為「切片」(slices) 的較小部分的 Cloud TPU Pods。我們時常看到 ML 團隊在各個 Cloud TPU 裝置 (可用的) 上開發初始模型,接著透過資料並行及模型並行逐步擴充到更大的 Cloud TPU Pod slices 來達到更好的訓練速度及模型規模。

您能夠從這個部落格文章或從這個互動式網站了解更多 TPUs 底層架構的資訊,且可以從此處學習到更多單個 Cloud TPU 裝置及 Cloud TPU Pod slices 的知識。

開始使用

現在開始透過這個互動式 Colab 在您的瀏覽器試用 Cloud TPU 是既簡單又有趣的,使您可以將預先訓練的 Mask R-CNN 圖像分割模型應用在您選擇的圖像上。您可以從這個部落格文章了解到更多關於 Cloud TPUs 上的圖像分割資訊。

接著,建議您透過我們的 Cloud TPU 快速入門,然後試著使用其中一項下面列出的優化和開源 Cloud TPU 參考模型。我們非常仔細優化了這些模型以節省您的時間和精力,並展示了各種 Cloud TPU 最佳實例。在規模較大的 pod slices 的公共資料集上對我們的官方參考模型進行基準測試是認識大規模 Cloud TPU 性能的好方法。

圖像分類

行動圖像分類

物件偵測

圖像分割

自然語言處理

- BERT (程式碼, 互動式 Colab)

- Transformer (教程, Tensor2Tensor 文件)

- Mesh TensorFlow (論文, 程式碼)

- QANet (程式碼)

- Transformer-XL (程式碼)

語音辨識

生成性對抗網絡

當您在 Cloud TPU 上使用了其中一項上述參考模型之後,我們的效能指南、分析工具指南及故障排除指南能為您提供深入的技術資訊,幫助你透過高級 TensorFlow APIs 自行創立優化機器學習模型。一旦您準備好,需要 Cloud TPU Pod 或 Cloud TPU Pod slices 來加速您自己的 ML 工作負載,歡迎您與 iKala GCP專門家聯絡。

(原文翻譯自 Google Cloud。)