想像一下,在未來所有員工可以藉由生成式 AI 來更快地完成工作,每一項任務都變得不再乏味且更具創新性,每一個應用程式都提供更有用、個人化的體驗。而要實現這個未來,企業需要的不僅僅是一個強大的大型語言模型 (LLM) 或聊天助手,他們需要完整的能力來建構和擴展適合自家業務和應用場景的生成式 AI 應用程式。本篇文章將介紹 Amazon Web Service (AWS) 的生成式 AI 服務,包含生成式 AI 助手 Amazon Q,以及讓生成式 AI 應用程式變得簡單且快速的開發平台 Amazon Bedrock。

AWS 如何從 Infra 到應用程式打造完整企業級生成式 AI 服務?

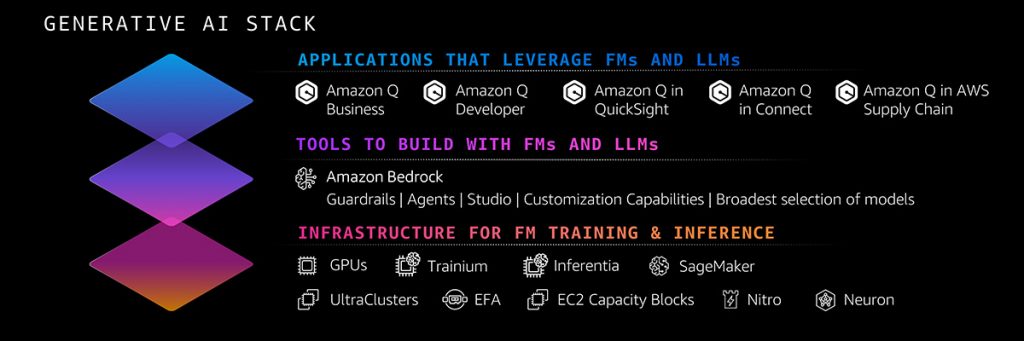

要提供企業級生成式 AI 服務,背後需要包括內建生成式 AI 的應用程式、快速實驗和建構生成式 AI 應用程式的工具,以及高效能的基礎設施,以及安全控制和防護措施。而正也是 AWS 積極建立一個全面的生成式 AI 技術堆疊的原因,在最上層, AWS 有生成式 AI 驅動的應用程式,包括生成式 AI 助手 Amazon Q,讓任何人都能夠透過撰寫簡單的自然語言指令來建構生成式 AI 應用程式;中間層則有 Amazon Bedrock,使得利用 LLM 和其他基礎模型 (FMs) 建構、部署和擴展生成式 AI 應用程式變得簡單且快速;而在底層,則是具備韌性與成本效益的基礎設施層,包括專為 AI 設計的晶片以及用於建構和運行 FMs 的 Amazon SageMaker。

在 2023 年初, AWS 推出的機器學習和生成式 AI 功能的總數是其他雲端服務供應商的 2 倍以上,這也是為什麼現在有數十萬客戶正在使用 AWS AI 服務的另一個原因。

AmazonQ 生成式 AI 助理,改變營運到開發部門日常作業模式

Amazon Q 是一款高效的生成式 AI 助理,不僅可以生成極為準確的程式碼,還具備測試、除錯以及多步驟規劃和推論能力,能夠執行如 Java 版本升級等各種程式碼轉換,並根據開發人員需求建立新程式碼。此外,Amazon Q 可以透過連接企業資料庫,進行資料總結、分析趨勢並執行資料對話,以便員工獲取公司政策、產品資訊、業績結果、程式碼庫、員工資訊等商業資料,從客戶和合作夥伴的數據看到,藉由 Amazon Q 可以幫助他們的員工提高80% 以上的工作效率 。Amazon Q 提供 Developer 和 Business 兩種版本,

- Amazon Q Developer:協助開發人員和 IT 專業人員完成各種任務,從程式設計、測試和升級應用程式,到排除故障、執行安全掃描和修復,以及優化 AWS 的雲端資料,將更多精力投入於優化程式,減少與程式設計無關的重複性維護工作。

- Amazon Q Business:協助不同部門員工根據企業系統內的資料和資訊回答問題、提供摘要、產生商業智慧(BI) 儀表板,和生成內容並安全地執行工作。旨在提升員工的創造力、資料驅動能力、效率、預備能力及生產力。

此外,為了讓所有員工能夠創建自己的生成式 AI 應用程式來自動執行任務, AWS 在 2024 年 7 月宣布全面推出 Amazon Q Apps,這是 Amazon Q Business 的一項功能。借助 Amazon Q Apps,員工只需在指令中描述他們想要的應用程式,Amazon Q 就可以在幾秒鐘內以公司資料做為基礎,創建生成式 AI 應用。 在預覽期間, AWS 看到用戶為各種任務產生應用程式,包括總結回饋、建立入職計劃、撰寫文案、草擬備忘錄等等。例如,資料安全供應商 Druva 創建了一個 Amazon Q 應用程式來支援其提案邀請書 (RFP) 製作流程,幾乎可以立即彙整所需訊息,從而將 RFP 回應時間縮短 25%。

2024 年 7 月 AWS 還推出了 AWS App Studio(預覽版),這是一項由 AI 驅動的生成式服務,使 IT 專案經理、資料工程師、企業架構師等技術人員能夠使用自然語言建立、部署和管理企業應用程式。使用 App Studio,用戶只需描述他們想要的應用程式、他們想要它做什麼以及他們想要整合的資料來源,App Studio 就可以在幾分鐘內建立一個應用程式。 App Studio 的生成式 AI 助理消除了典型低程式碼工具的學習曲線,加速了應用程式流程的建立,以及簡化了 UI 設計 、建置工作流程和測試應用程式等常見任務。

生成式 AI 應用程式開發平台 Amazon Bedrock 功能再升級

Amazon Bedrock 是建置和擴展安全生成式 AI 應用程式最快、最簡單的方法,提供最廣泛領先的 LLM 和基礎模型 (FM) 選擇,以及易於開發人員使用的功能。數以萬計的客戶已經在使用 Amazon Bedrock,它是 AWS 在過去十年中成長最快的服務之一。例如,法拉利正快速為客戶、經銷商和內部團隊推出新體驗,以執行更快速的模擬、建立協助經銷商和技術使用者的新知識庫、提升賽車迷體驗,以及在數秒內從法拉利提供的數百萬種選項中為客戶建立高度個人化的車輛推薦。

自 2024 年初以來, AWS 宣布 Amazon Bedrock 全面推出比其他雲端供應商同類型服務更多的特點和功能,以幫助客戶更快地從概念驗證到生成式 AI 應用程式的生成。這包括對 Anthropic、Meta、Mistral 等產業領先模型的支援,以及近期新推出的 Anthropic Claude 3.5 Sonnet,這是他們迄今為止最先進的模型。

iKala 在先前的文章中,也介紹了 Anthropic 所發佈的 Claude 3 基礎模型系列,目前三個模型皆可在 Amazon Bedrock 中使用,針對台灣用戶也推出 Claude 3 Sonnet 及 Claude 3 Haiku 等模型的每日限量免費試用

- Claude 3 Haiku:最快且最緊湊的模型,可實現近乎即時的回應能力

- Claude 3 Sonnet,在技巧與速度之間的理想平衡的模型

- Claude 3 Opus,能在高度複雜的任務上提供頂級性能的產品。

2024 年 7 月, AWS 再次宣布了一些在 Amazon Bedrock 服務上的重大創新。

第一部分,協助企業用自己的數據產出生成式 AI 應用程式,包含以下三項內容

- 在 Amazon Bedrock 中微調 Anthropic 的 Claude 3 Haiku:有了 Amazon Bedrock,您可以透過在 Amazon Simple Storage Service (Amazon S3) 中提供標記資料,私下且安全地微調 Amazon Titan、Cohere Command 和 Command Lite 以及 Meta Llama 2 模型,以針對您的業務和個案打造專屬模型。 7 月開始,Amazon Bedrock 也是唯一能提供您微調 Anthropic 的 Claude 3 Haiku (預覽中) 的全面管理服務。

- 增加更多資料來源強化檢索增強生成(RAG):有了 RAG,企業可以從多個來源(包括文件儲存庫、資料庫和 API)為模型提供新知識或最新資訊。例如,模型可能會使用 RAG 從 Amazon OpenSearch Service 擷取搜尋結果,或從 Amazon S3 擷取文件。Knowledge Bases for Amazon Bedrock 可透過連接您的私有資料來源,包括 Amazon Aurora、Amazon OpenSearch Serverless、MongoDB、Pinecone 和 Redis Enterprise Cloud,完全管理這種體驗。 7 月開始 AWS 擴大了清單,加入了 Salesforce、Confluence 和 SharePoint (預覽中) 的連接器,因此企業可以利用更多的商業資料,針對特定需求自訂模型。

- 推出更快的向量搜尋服務 Amazon MemoryDB :為了進一步強化您的 RAG 工作流程,AWS 已將向量搜尋加入一些最受歡迎的資料服務,包括 OpenSearch Service 和 OpenSearch Serverless、Aurora、Amazon Relational Database Service (Amazon RDS) 等。客戶可以將向量資料與作業資料共置,減少管理另一個資料庫的開銷。 7 月開始 AWS 宣佈 Amazon MemoryDB 的向量搜尋功能已全面上市,Amazon MemoryDB 能以最高的召回率提供最快的向量搜尋效能,因此非常適合需要單位數位毫秒延遲的使用個案。例如,Amazon Advertising、IBISWorld、Mediaset 和其他組織正在使用它來提供即時語意搜尋,而 Broadridge Financial 正在執行 RAG,同時提供客戶習慣的即時回應率。

第二部分,將 Agents for Amazon Bedrock 升級,提供更優化、個人化的使用體驗:透過 Agents for Amazon Bedrock,應用程式可以採取行動,利用公司系統和資料來源執行多步驟任務,大幅提升 AI 應用程式的實用性。不過,過去 Agents 只能根據單一對話中的資訊採取行動。從 7 月起,Agents 可以在多次互動中保留記憶,記住您上次離開的位置,並根據之前的互動提供更好的建議。例如,在航班預訂應用程式中,開發人員可以創建一個 Agent,它可以記住您上次旅行的時間或您選擇素食的時間。Agent 現在也可以解讀程式碼,以處理複雜的資料驅動使用個案,例如資料分析、資料視覺化、文字處理、解方程和最佳化問題。例如,應用程式使用者可以要求分析不同郵遞區號的歷史房地產價格,以找出投資機會。

第三部分,藉由 Guardrails 提升 Amazon Bedrock 安全性:生成式 AI 幻覺問題是許多使用者關注的議題,即 LLM 透過混淆多項資訊、提供不正確資訊或編造新資訊,產生不正確的回應。7 月開始,在 Amazon Bedrock 的 Guardrails 中加入上下文基礎檢查,以偵測使用 RAG 和總結應用程式的模型回應中的幻覺。Contextual grounding 檢查可在 Guardrails for Amazon Bedrock 中加入領先業界的安全防護,可偵測並過濾 RAG 和總結工作負載 75% 以上的幻覺回應,以確保 LLM 回應是基於正確的企業來源資料,並評估 LLM 回應以確認它與使用者的查詢或指令相關。

現今,許多 AWS 客戶已經利用 Amazon Bedrock 不斷擴展的能力來定制他們的生成式 AI 應用程式,以滿足不同產業和業務功能的需求。例如,Deloitte 正在利用 Amazon Bedrock 的進階客製化功能,建立專為 CFO 設計的 C-Suite AI™ 解決方案。它利用 Deloitte 的專屬資料和專精於財務產業的深度。C-Suite AI 可針對財務長的需求提供客製化 AI 模型,應用程式涵蓋關鍵財務領域、資料驅動洞察力的產生式分析、合約情報以及投資人關係支援。