生成式 AI 因為擅長理解語言的細微差別,和上下文相關含義,讓無論是在搜尋公司內部的資料,或是瀏覽公共網站,都能讓搜尋體驗更加優化;然而「 AI 幻覺」卻是令人相當頭痛的問題,在於可能會出現看似合理,但卻違反事實、無關的回覆內容。因此,透過檢索增強生成 (RAG)技術,企業可以將大型語言模型(LLM) 的回應,建立在企業數據和系統這些資料上,以提供更新、更準確的回覆。本篇文章將介紹企業為何需要關注 RAG,以及 Google Cloud 如何提供快速、方便的 RAG 方案,以協助企業打造新一代的搜尋體驗。

什麼是檢索增強生成 (RAG)?

檢索增強生成 (RAG) 是一種 AI 架構,結合傳統資訊檢索系統 (例如資料庫) 的優勢,以及生成式大型語言模型 (LLM) 的功能。RAG 會採 2 步驟來提升生成式 AI 輸出內容的品質。

- 擷取及預先處理:RAG 會運用強大的搜尋演算法來查詢外部資料,例如網頁、知識庫和資料庫。完成擷取作業後,系統就會開始預先處理相關資訊,包括斷詞、分析詞幹,以及移除非檢索用字。

- 生成內容:接著,經過預先處理的擷取資訊便能順暢整合至預先訓練的 LLM。這項整合流程可增強 LLM 的脈絡理解能力,更全面地瞭解主題。一旦脈絡理解能力提升,LLM 就能生成更精確、實用且引人入勝的回覆。

同時,RAG 相較傳統 LLM 更擁有存取最新資訊、依事實查核、符合內容關聯性,以及運用向量資料庫,搜尋更快且精準等優勢。

為何 RAG 對企業生成式 AI 應用很重要?

如同開頭提到生成式 AI 可能因為訓練資料不完整,或含有偏誤,導致預測結果不準確或產生「幻覺」的問題,或是因為缺乏適當的資料依據,而輸出看似合理,但實際上違反事實、或毫無意義的內容。例如某個 AI 模型原先設計用來統整新聞報導,但生成的內容中卻出現原始文章未報導的細節,甚至是憑空捏造資訊。

而檢索增強生成 (RAG) 正能克服這項限制,它讓 LLM 可以存取最新的外部資訊來源,例如企業資料庫、知識庫和網站,確保 LLM 可以提供最新、準確,且和公司業務情境相關的回應。因此,對於著重準確率的應用情境 ,例如:報導新聞、撰寫科學內容或提供客戶服務,RAG 在生成式 AI 應用上格外實用。

3 個結合 RAG 而生的新興搜尋方式

隨著 RAG 技術的發展,企業能夠在生成式 AI 中結合外部知識庫,有效提升模型的準確性與相關性。但 RAG 的應用遠不止於此,它還徹底改變了現代搜尋的方式,LLM 能夠將冗長的多模態資料(文字、圖像)轉換為數字表示(嵌入),同時保留大量不同資料的語義關係,相較傳統以語意和關鍵字為基礎的搜尋系統,嵌入式系統能夠更準確地詮釋搜尋查詢。以下三種為現今在不同產業新興的搜尋方式

增強型語意搜尋 (Enhanced Semantic Search)

跨不同領域(包括法律、財務、研究或人力資源)的企業通常擁有大量的非結構化文檔,例如 pdf、文件、網站,藉由 RAG 方案能幫助企業超越傳統關鍵字搜尋的限制,深入理解使用者查詢的語義和上下文。 例如,在金融服務領域,承銷商可以使用增強型語意搜尋快速找到大量保單文件中與理賠相關的資訊和條款。

混合搜尋 (Hybrid Search)

混合搜尋結合關鍵字搜尋和語意搜尋的優點,讓使用者可以根據關鍵字和語義的組合找到相關資訊。 例如,在零售產業,使用者可以使用混合搜尋同時搜尋特定產品型號(例如 「LED」)和描述產品特徵(例如 「適合陽台的小型裝飾燈」)。

分析型搜尋 (Analytical Queries)

隨著 LLM 出現,大眾對於搜尋的體驗與結果有更精準的需求,分析型搜尋讓使用者可以用自然語言搜尋資料,並獲得彙整的分析結果,而不僅是單一文件。 例如,使用者想查詢 「2024 年和 2022 年的碳排放總量」,系統會直提供彙整後的答案,而不僅是單純包含關鍵字的文件。由於分析型搜尋需要理解複雜的資料結構和語義,因此在建構這類搜尋系統更具挑戰性,而由 LLM 驅動的 RAG 便是支援此類應用的工具之一。

Vertex AI 打造 2 種企業專用 RAG 方案

儘管結合 RAG 為企業帶來全新的搜尋體驗,但 RAG 系統的建置和管理相當複雜。開發人員需要開發和維護多個 RAG 建立區塊,包含資料連接器、資料處理、分塊、註解、內嵌向量化等等,往往需耗費大量時間在這些管道的設計、建置和維護作業。更有甚者,隨著查詢量的增加,處理突發流量和大量頻繁更新的數據更是一大挑戰,許多向量資料庫在每秒查詢次數增多時,回應速度和延遲表現會變差。

因此,Google 在 Vertex AI Search 中結合 Google 過往在資訊擷取、NLP 和 LLM 技術的專業知識,去理解使用者的搜尋意圖並提供最相關的結果。並且,Vertex AI Search 提供從開箱即用到 DIY RAG 的多樣選項。

延伸閱讀:Vertex AI 大更新 – 企業能利用生成式 AI 的建構無限可能

一、開箱即用的 RAG 方案 Vertex AI Search

適用對象

針對希望快速部署 AI 搜尋解決方案,但技術資源較有限的中小企業、非技術型公司;或是擁有大量文檔、報告或內部資料的企業,如法律、諮詢、金融機構等,開箱即用的 RAG 方案能夠幫助快速導入 AI 搜尋系統,提升員工的工作效率;同時,對於電商網站、媒體平台或知識分享平台等需要為用戶提供精準搜索體驗的企業,能夠利用 Vertex AI Search 提供與查詢相關度高的產品或內容推薦,優化使用者體驗。

主要功能

- 多項資料來源連連接器: 協助企業輕鬆連接如 Cloud Storage、BigQuery、Salesforce、Confluence、Jira 和 Slack 等各種資料來源

- 先進的文件排版解析器:可以理解文件的結構,並擷取相關資訊,即使在包含表格和圖像的複雜文件中也能如此

- 混合搜尋功能:結合關鍵字搜尋和語意搜尋,為使用者提供更靈活和直觀的搜尋體驗

- LLM 支援的摘要和引用功能:支援自訂 LLM 指令模板,可以輕鬆以最少的努力創建強大且引人入勝的搜尋體驗

優勢

- 易於使用和設定,能協助企業縮短應用程式上市時間

- 提供 Google 等級的搜尋品質和效能

- 企業可以減少開發和維護工作來節省時間和資源

二、DIY RAG 方案 Vertex AI DIY Builder API

適用對象

適合能夠利用 API 自主開發並部署自定義 AI 模型技術成熟的企業;或是需要處理大量、複雜數據的企業,如金融、電信和醫療業,能透過 DIY Builder API 自定義其 AI 解決方案,滿足特定數據分析與預測需求;或是有高度客製化 AI 方案來滿足特定業務需求的企業,如製造業、物流業,能根據其獨特的工作流程調整 AI 系統。

主要功能

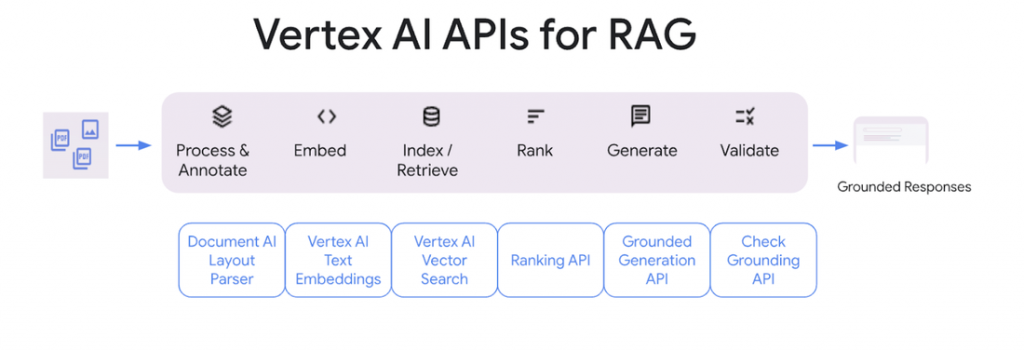

- 提供建構自定義 RAG 解決方案所需的基本模組:包括文檔解析、分塊、嵌入、向量資料庫選項、重新排序 API 和基礎檢查的 API。

- 與 Langchain 和 LlamaIndex 等開源框架整合:透過與語言模型應用、文本資料索引等開源康價結合,使開發者能夠更加靈活地構建和擴展 RAG 解決方案。

- 與 Vertex AI Search 整合:DIY Builder API 與 Vertex AI Search 的整合提供了更強大的搜尋結果檢索和排序能力,使企業能夠在處理大規模查詢時,享受即時的、高準確性的搜尋服務,同時也讓生成的答案更加精確、相關,適用於各種商業場景。

優勢

- 提供最大的靈活性,可以根據特定需求制定每個 RAG 元件。

- 允許與自定義 LLM 和其他自定義元件整合。

- 為需要完全控制其 RAG 管線的企業提供更大的靈活性。

RAG 技術正在徹底改變我們的搜尋模式,從傳統的關鍵字匹配轉向更智慧的意圖理解和上下文分析,透過檢索增強生成 (RAG),搜尋結果不再僅僅依賴於單純的資料對比,而是基於查詢的深層意圖提供更精確和相關的答案。隨著這種技術的發展,企業能夠更好地應對資料量增長和用戶需求的多樣性。而現在,Vertex AI 也為企業提供了強大且靈活的工具,無論是開箱即用的搜尋解決方案,還是自定義的 RAG 系統,都能夠幫助企業迅速開發和部署搜尋服務,提升用戶體驗與業務競爭力。